SEOにおけるクロール

SEO対策では、検索意図に合った高品質なコンテンツを作成することは非常に重要です。

そのコンテンツが良質なものでなければ、検索結果に表示されることはありません。

クロールはSEOにとって重要であり、頻繁にクロールされることで最新情報が正確にインデックスされ、検索評価にも好影響を与えます。

※インデックスも専門用語。

そもそもクロールとは何か?

SEOにおける「クロール」とは、GoogleやBingなどの検索エンジンに属するクローラー(ロボットプログラム)が、ウェブ上を巡回してページ情報を収集するプロセスを指します。

具体的には、クローラーがウェブページのテキストや画像、リンク、構造情報などを読み取り、検索エンジンに送信します。

その後、収集された情報が検索エンジンのデータベースに登録(インデックス)されることで、はじめてそのページは検索結果に表示されるようになります。

Webページを公開後の流れと知って知っておきたいのが、

「クロールされる

→ インデックスされる

→ 検索順位が決まる」

という一連の流れになります。これは、SEO対策の大前提です。

次から、SEOにおけるインデックスの流れ、そしてクロールされやすくするための対策(クローラビリティの改善方法)について詳しく解説していきます。

インデックスとは?

インデックスとは、ウェブページが検索エンジンのデータベースに登録されることを指します。

より正確にいえば、検索エンジンがページ内のテキスト、画像、動画などのコンテンツを解析し、検索アルゴリズムに沿って整理・分類したうえで登録することを「インデックスされる」といいます。

ウェブページが検索結果に表示されるためには、このインデックスが前提条件となります。

検索エンジンごとのクローラーの種類

クローラーは検索エンジンによって異なります。代表的なクローラーは以下の通りです。

Google: Googlebot

Bing: Bingbot

Yahoo!: 日本ではGooglebotを使用/海外ではBingbotを使用

Baidu(百度): Baiduspider

日本国内においては、Googleが圧倒的なシェアを占めており、Yahoo!もGoogleの検索エンジンを採用しているため、Googlebotの仕組みを理解することが最も重要です。

Googlebotとは?

Googlebotとは、Googleが運用するクローラーの総称です。

主に以下の2種類があります:

デスクトップ向けクローラー

モバイル向けクローラー

現在は、Googleが導入している「モバイルファーストインデックス(MFI)」の影響により、ほとんどのサイトがスマートフォン版のGooglebotによってクロールされています。

したがって、ウェブサイトをモバイルフレンドリーにしておくことは、SEOの基本とも言える対応です。

○先程ご説明したように、インデックスされるためにはまずクロールについて考えることが必要です。

クロールの流れとしては、

・ウェブ上のリンクをたどりながらページを発見し、順にクロールしていきます。

・つまり、内部リンクの構造が整理されていることが、クロールされやすいサイト作りには不可欠です。

クロールを促進する方法(公開後すぐに行って欲しい場合)

Googleのクローラーは非常に高性能で、特別な対策を施さなくても多くの場合、自然とサイトを巡回してくれます。

しかし、自然クロールには時間がかかることが多く、公開したばかりの情報をできるだけ早く検索結果に反映させたい場合は、クロールを促す施策が重要です。

コンテンツ公開後すぐにクロールしてもらうためには、以下の2つの対策を必ず行いましょう。

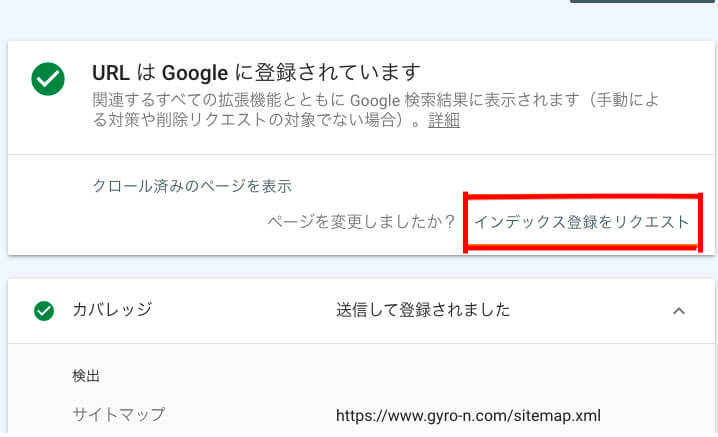

1. Google Search Consoleでクロールリクエストを送信する

Googleが提供する無料のツール「Google Search Console」には、任意のURLを即座にクロールさせる機能があります。

これにより、インデックス登録のスピードが大きく向上します。

リクエスト手順:

Google Search Console にログインし、対象のサイト(プロパティ)を選択

上部の「URL検査」フィールドに、クロールしたいページのURLを入力

「公開URLをテスト」をクリックして、インデックス可能かどうかを確認

問題がなければ「インデックス登録をリクエスト」をクリック

この操作により、該当URLはGoogleの優先クロールキューに追加され、通常よりも早いタイミングでクロールされるようになります。

多くの場合、24時間以内にインデックス登録が完了しますが、サイトの状態や評価によっては数日かかることもあります。

もし1週間以上たってもインデックスされない場合は、別の技術的な問題がある可能性があるため、改めて確認が必要です。

Google Search ConsoleのURLはこちら↓

https://search.google.com/search-console/about?hl=ja

2. XMLサイトマップを作成・送信する

XMLサイトマップ(sitemap.xml)は、Googleなどの検索エンジンに対して「インデックスしてほしいURLの一覧」を明示的に伝えるための重要なファイルです。

自然クロールの効率を上げるだけでなく、更新情報を正しく伝えることができるため、SEO内部対策の基本のひとつとされています。

サイトマップの送信方法:

Google Search Consoleの「サイトマップ」セクションから、設置済みのXMLサイトマップのURLを入力して送信

これにより、Googleに最新のサイト構成が即時通知され、クロールの優先度が上がります

補足:Ping送信を活用する方法

また、ブラウザのアドレスバーから直接Pingを送る方法もあります。

上記のように、sitemap=の後に自サイトのXMLサイトマップURLを付けてアクセスします。

「Sitemap notification received successfully」などのメッセージが表示されれば、正常に通知されています。

クローラビリティを改善するためのポイント!

クローラビリティを促進する(クロール頻度を上げる)ためには、クローラーにとって巡回しやすいサイト構造を意識することが重要です。ここでは、クローラビリティ向上のために実践すべき内部対策をご紹介します。

1. パンくずリストを設置する

パンくずリストは、ページがサイト内でどの位置にあるかをユーザーとクローラーの両方に伝えるナビゲーション要素です。

検索エンジンのクローラーにとっても、サイト構造を把握しやすくなるため、サイト全体のクロール効率が向上します。

クローラーの巡回性向上

ユーザーの操作性向上(UX)

ユーザビリティとクローラビリティの両面でメリットがあるため、すべてのサイトに設置を推奨します。

2. 内部リンクを最適化する

コンテンツ同士を関連性の高いページ同士で内部リンクすることで、クローラーの巡回効率を高めることができます。

リンクが適切に構築されていれば、クロール頻度やインデックス精度が向上し、SEOにも好影響を与えます。

トピックが近いページ同士をつなぐ

トップページやカテゴリーページからのリンクを活用する

関連性の低いページへのリンクは避ける

また、クロール頻度の高いページからリンクを張ることで、新しいページも早くクロールされやすくなります。

3. ディレクトリ階層を深くしない

クローラーはリンクをたどってページを発見しますが、階層が深いと発見までに時間がかかり、クロールされにくくなる可能性があります。

可能な限りディレクトリ階層は浅く設計する

階層が深くなる場合は、内部リンクやサイトマップでカバーする

なお、浅い階層=SEO評価が上がるというわけではなく、内部リンク構造がしっかりしていれば、深い階層でも問題ありません。

4. ページスピード(読み込み・レンダリング速度)を改善する

クローラーはHTMLだけでなく、CSSやJavaScriptも含めてページ全体をレンダリングして情報を取得します。

このレンダリングに時間がかかると、クローラーが途中で取得を中断してしまう可能性があり、インデックスされない原因にもなります。

つまり、表示速度=クロール効率に直結する重要な要素です。

レンダリングの遅延が引き起こす問題:

クロール対象の情報が取得されない

インデックスに時間がかかる、またはインデックスされない

Googleのランキング要因であるページスピードに悪影響

5. Core Web Vitals(コアウェブバイタル)を意識する

Googleは、ページエクスペリエンスの一部としてコアウェブバイタル(ユーザーにとって使いやすいかの指標)をランキング要因に導入しています。

以下の3つの指標は、UX(ユーザー体験)だけでなくクローラビリティ改善にも影響します。

| 指標 | 内容 | 理想値 |

|---|---|---|

| LCP(Largest Contentful Paint) | 最大のコンテンツが表示されるまでの時間 | 2.5秒以内 |

| INP(Interaction to Next Paint) | 操作に対する応答までの遅延時間 | 200ミリ秒以内 |

| CLS(Cumulative Layout Shift) | レイアウトのズレの発生頻度 | 0.1未満 |

※特にLCPとINPはページスピードと密接に関係しており、改善することでクローラーの処理効率も向上します。

ウェブページをクロールさせたくない場合

通常、SEOではページを検索エンジンにクロールさせることが基本ですが、以下のようにクロールを避けたいページも存在します。

会員専用ページや個人情報を含むページ

テストページや開発中ページ

低品質なコンテンツと見なされるページ

これらのページを検索結果に表示させたくない場合、noindex を利用する方法がありますが、そもそもクロール自体をさせたくない場合には、以下の2つの手段を取ることが可能です。

1. robots.txt を使用する

robots.txt は、検索エンジンのクローラーに対して「どのページをクロールすべきか」を指示するテキストファイルです。

注意点:

robots.txtでブロックされたページは、クロール自体が行われないため、ページ内のnoindexタグも検索エンジンに認識されません。インデックス制御を目的とする場合は、

robots.txtよりもnoindexを使うべきです。誤って重要ページのURLを記述してしまうと、検索結果から除外される事故につながります。

➡ 必ず Google Search Console の「robots.txt テスター」でテストし、内容を確認してから公開しましょう。

2. Basic認証を使用する

Basic認証(ベーシック認証)は、指定したページやディレクトリにアクセスする際にパスワードを要求する方法です。

この設定により、検索エンジンのクローラーもパスワード入力ができないため、クロールを回避することが可能です。一般的な設定方法として「.htaccessファイル」を利用する方法が一般的です。

まとめ

SEOの本質は、検索ユーザーの意図に合った価値あるコンテンツを提供し、それが検索エンジンに適切にクロール・インデックスされる環境を整えることにあります。

中でも「クローラビリティの向上」は、検索エンジンにページの内容を正しく伝え、インデックス精度や検索順位に影響を与える重要な内部対策です。

クローラーの仕組みや動きを理解し、検索エンジンにとって巡回しやすい構造と運用を心がけましょう。